Erstellen von Baselines für die Neuerstellung von Exchange-Inhaltsindizes – Teil 3

Veröffentlichung des Originalartikels: 02.07.2012

In Teil 1 dieser Reihe habe ich das Skript E2K7_IndexRebuildAnalyzer.ps1 erläutert, und in Teil 2 habe ich das von Anatoly Girko und mir entwickelte Search Rebuild Framework besprochen. Vor dem Abschluss dieser Reihe wollte ich Ihnen eine Reihe von Diagrammen und eine Tabelle mit “beobachteten Durchschnittswerten” zur Verfügung stellen, um die Neuerstellungseigenschaften zu veranschaulichen, die wir seit den Anfängen des Frameworks beobachtet haben. Ich hoffe, dass dies eine bessere Konzeptualisierung ermöglicht und Sie in die Lage versetzt, bessere Schätzungen bei der Berechnung Ihrer eigenen Neuerstellungsraten anzustellen.

Bis dato bei Microsoft beobachtete Durchschnittswerte

Anatoly und ich überlegten hin und her, wie wir diesen Teil am besten präsentieren sollten. Wie Sie sich vorstellen können, gibt es unendlich viele Möglichkeiten, solche Inhalte zu veranschaulichen. Wir beschlossen, den Umfang der Diagramme und Tabellen auf die Nachrichtengröße zu beschränken, für die die meisten Exchange-Speicherarchitekten entwickeln: 150 kB pro E-Mail-Element. Dann wendeten wir einen sekundären Filter auf Anzahl der Postfächer an und bezogen für die Gewinnung der unten aufgeführten Durchschnittswerte nur die Postfachdatenbanken in unseren Datensammlungen ein, die mindestens 100 aktive Postfächer enthielten. Anschließend entfernten wir die 10 % Neuerstellungsvorgänge mit der besten Leistung und die 10 % mit der schlechtesten Leistung aus unserer Sammlung und leiteten dann die Durchschnittswerte für die Erstellung der Diagramme und Tabellen ab.

Hinweis: In den nachstehenden Diagrammen und Tabellen fehlt in mehreren Bereichsschritten die durchschnittliche Postfachgröße. Diese Daten wurden weder übersehen noch absichtlich weggelassen. Dass statistische Werte für diese Bereiche fehlen, liegt an der Tatsache, dass in unseren Sammlungen von historischen Daten keine gültigen Daten vorhanden sind. Anders gesagt: Für Datenbanken, in denen die durchschnittliche Postfachgröße für Endbenutzer-Postfächer sich in den folgenden Bereichen bewegten, haben wir noch nie Neuerstellungsvorgänge für Inhaltsindizes ausgeführt und/oder Metriken nach der Neuerstellung gesammelt:

- 1700-1799 MB

- 1800-1899 MB

- 2000-2099 MB

- 2100-2199 MB

Diagramme

Wir präsentieren vier Excel-PivotCharts, die die Durchsatzwerte widerspiegeln, die wir bis dato basierend auf der oben beschriebenen gefilterten Sammlung beobachtet haben. Diese PivotCharts sollen die Beziehung zwischen den verschiedenen Eigenschaften innerhalb und außerhalb des Postfachspeichers veranschaulichen (z. B. Anzahl der Postfächer, Anzahl der Elemente und EDB-Dateigrößen) und sie mit den historischen Werten für die Dauer der Ausführung von vollständigen Durchforstungen in Postfachspeichern mit ähnlichen Merkmalen vergleichen.

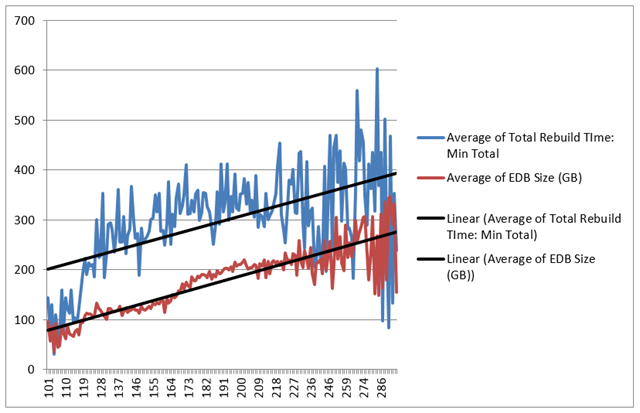

Diagramm 1

Die Darstellung in Diagramm 1 zeigt speziell die Beziehung zwischen der Anzahl der Postfächer pro Datenbank und der relativen Größe der Postfachdatenbanken in Gigabytes einerseits und deren Auswirkung auf die Dauer der Ausführung der vollständigen Neuerstellung der Inhaltsindizes der Postfachspeicher in Minuten andererseits.

Dieses Diagramm belegt klar, dass parallel zur Anzahl der aktiven Postfächer in einer Exchange-Postfachdatenbank auch die EDB-Dateigrößen im Speichersubsystem tendenziell zunehmen. Diese Beziehung wirkt sich letztlich auch auf die Gesamtdauer der Ausführung einer vollständigen Durchforstung eines Inhaltsindex aus. Einfacher ausgedrückt: mehr aktive Postfächer bedeuten meist mehr E-Mail-Elemente; mehr E-Mail-Elemente bedeuten größere EDB-Dateien auf dem Datenträger; je größer eine EDB-Datei auf dem Datenträger, umso länger dauert "normalerweise" die Neuerstellung eines Inhaltsindex. Der einzige Fall, in der diese Hypothese nie zutrifft, ist eine Postfachdatenbank, in der viel Leerraum in der Datei vorhanden war. In diesem Fall ist die Gesamtdauer der Ausführung einer Inhaltsindex-Neuerstellung deutlich kürzer als erwartet. Diese Anomalie haben wir bei den von uns unterstützten Umgebungen beobachtet, aber die nachfolgenden Statistiken haben wir mithilfe des oben beschriebenen Filterverfahrens aus unserer Sammlung entfernt.

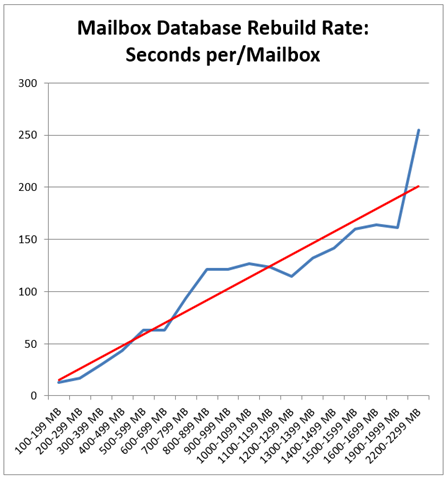

Diagramm 2

Diagramm 2 zeigt die Auswirkungen der durchschnittlichen Postfachgröße (für Postfächer in Datenbanken, die sich im gleichen gefilterten Beispielsatz befinden) auf den Durchsatz der Inhaltsindex-Neuerstellung auf Postfachdatenbank-Ebene in Sekunden pro Postfach.

Dieses Diagramm untermauert im Prinzip das in Diagramm 1 veranschaulichte Argument, wenn auch auf der Ebene der aktiven Postfächer. Insbesondere steigt mit der Durchschnittsgröße der aktiven Postfächer auch die durchschnittliche Anzahl der E-Mail-Elemente in diesen Postfächern an. Im Schnitt lässt sich sagen, je mehr E-Mail-Elemente ein Postfach enthält, umso länger braucht die Suchindizierung für die Durchforstung in einem bestimmten Postfach, was sich wiederum auf die Dauer der Ausführung der vollständigen Durchforstung für alle Postfächer in der Datenbank auswirkt.

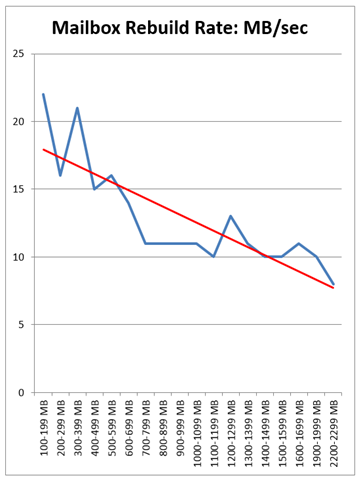

Diagramm 3

Diagramm 3 zeigt die Auswirkungen der durchschnittlichen Postfachgröße (für Postfächer in Datenbanken, die sich im gleichen gefilterten Beispielsatz befinden) auf den Durchsatz der Inhaltsindex-Neuerstellung in Megabyte pro Sekunde.

Diagramm 3 knüpft an die Hypothese aus Diagramm 2 an. Insbesondere zeigt es Folgendes: Je höher die durchschnittliche Postfachgröße und die durchschnittliche Anzahl der Elemente in einer Postfachdatenbank, umso niedriger der Durchsatz der Suchindizierung. In Diagramm 3 wird diese Beziehung in Megabyte pro Sekunde dargestellt.

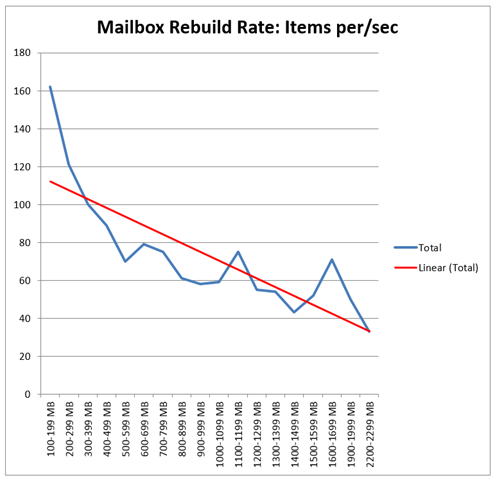

Diagramm 4

Diagramm 4 zeigt die Auswirkungen der durchschnittlichen Postfachgröße (für Postfächer in Datenbanken, die sich im gleichen gefilterten Beispielsatz befinden) auf den Durchsatz der Inhaltsindex-Neuerstellung in Elementen pro Sekunde (basierend auf einer durchschnittlichen Nachrichtengröße von 150 kB) :

Ähnlich wie das Diagramm 3 zeigt Diagramm 4 die negative Auswirkung auf die Leistung hinsichtlich des Durchsatzes, hier in Elementen pro Sekunde.

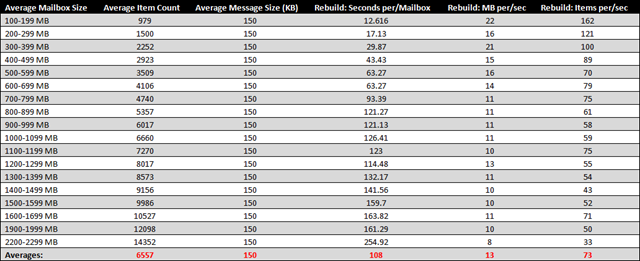

Tabelle der beobachteten Durchschnittswerte

Für die Zusammenstellung der Tabelle haben wir den gleichen Filtersatz verwendet (wie oben beschrieben und in den Diagrammen dargestellt), aber fokussierte Durchschnittswerte basierend auf der durchschnittlichen Postfachgröße erstellt. Diese Datensätze werden nachfolgend in 99-MB-Schritten in einzelne Zeilen aufgeschlüsselt. Der Durchsatzwert für jede Zeile stellt die aggregierten Durchschnittswerte für alle Datenbanken ähnlicher Größe dar, für die abgeschlossene Neuerstellungsvorgänge in unserer Sammlung vorhanden sind. Besonders wenn die durchschnittliche Nachrichtengröße 150 kB war und die durchschnittliche Postfachgröße für alle aktiven Postfächer in diesen Datenbanken innerhalb der in Spalte A definierten Bereiche lag.

Die historischen Durchschnittswerte in dieser Tabelle eröffnen (zumindest mir) drei Möglichkeiten, die Dauer von Inhaltsindex-Neuerstellungsvorgängen zu schätzen:

- Ein "Historischer Durchschnitt" könnte basierend auf der durchschnittlichen Postfachgröße implementiert werden, wobei die durchschnittliche Nachrichtengröße für Elemente in diesen Postfächern 150 kB beträgt.Da unsere Sammlung große Mengen von historischen Neuerstellungsdaten enthält, verwenden wir diesen Durchschnittswert. Unsere Schätzung leiten wir durch Ermittlung der durchschnittlichen Postfachgröße über Metriken "vor der Neuerstellung" und Vergleich dieses Werts mit dem historischen Durchschnittswert ab. Anschließend nehmen wir den zusammengesetzten Durchschnittswert für Neuerstellung: Sekunden pro Postfachund multiplizieren ihn mit der Anzahl der Postfächer in der Datenbank, die durchforstet werden müssen, um die Gesamtdauer der Ausführung zu bestimmen.

- Außerdem könnte ein "Organisationsdurchschnitt" basierend auf der durchschnittlichen Nachrichtengrößeunabhängig von der Anzahl der Elemente und der durchschnittlichen Größe der Postfächer in der gesamten Organisation definiert werden (dieser Organisationsdurchschnitt ist in der obigen Tabelle in der Zeile "Durchschnitte" angegeben).

- Ein zusammengesetzter Durchschnittswert aus historischem Durchschnitt und Organisationsdurchschnitt.

Wenn ich beispielsweise einen Inhaltsindex, der neu erstellt werden muss, für eine Datenbank habe, deren Benutzer eine zusammengefasste durchschnittliche Postfachgröße im Bereich von 500 bis 599 MB haben, und die durchschnittliche Nachrichtengröße 150 kB beträgt, könnte ich, wenn die Datenbank 200 Benutzer hat, die Schätzung auf einem der drei folgenden möglichen Wege ableiten:

Tabelle "Historische Durchschnitte" :

200 Postfächer * 63 Sekunden = 12.600 Sekunden insgesamt. Dies entspricht 210 Minuten oder rund 3,5 Stunden Ausführungsdauer der vollständigen Durchforstung.

"Organisationsdurchschnitt" :

200 Postfächer * 108 Sekunden = 21.600 Sekunden insgesamt. Dies entspricht 360 Minuten oder rund 6,0 Stunden Ausführungsdauer der vollständigen Durchforstung.

Zusammengesetzter Durchschnittswert (Durchschnitt aus "Historisch" und "Organisation") :

3,5 + 6,0 = 9,5 Stunden

9,5 / 2 = 4,75 Stunden

Schlussbemerkung

Die Gesamtdauer einer Inhaltsindex-Neuerstellung wird immer unterschiedlich sein, weil Postfächer und darin enthaltene Elemente ebenfalls immer unterschiedlich sind. Beim Neuerstellen von Inhaltsindizes werden die genauesten und zuverlässigsten Schätzungen immer unter Berücksichtigung von historischen Durchschnittswerten gewonnen. Ich möchte auch nochmal darauf hinweisen, dass wir, wenn wir eine Neuerstellung von Inhaltsindizes intern bei MSFT beschließen, diese möglichst für Zeitintervalle terminieren, an denen die Auswirkungen auf die Benutzer so gering wie möglich sind. Allerdings sind unsere Implementierungen global, sodass es mehr oder weniger unmöglich ist, diese Auswirkungen ganz auszuschließen. Das Optimum, das man erwarten kann, ist, die Auswirkung auf den Oberflächenbereich zu minimieren. Darüber hinaus beziehen wir in unseren Datensammlungen keine Drosselungsverzögerungen der Suchindizierung ein. Alle Drosselungsverzögerungen der Suchindizierung bei Neuerstellungen werden im selben Moment behandelt und sind innerhalb der einzelnen Tickets repräsentativ. Mithilfe der Filterverfahren, die in diesem Beitrag angewendet wurden, können Sie Ihre Zahlen von diesen negativen Durchschnittswerten isolieren (das gilt auch für Neuerstellungsvorgänge mit "übermäßig hohem Durchsatz"). Dadurch sind Ihre allgemeinen Schätzungen erheblich genauer.

Wenn Sie der Typ sind, der gerne auf Durchschnittswerte setzt, kann ich das voll und ganz verstehen. Sollte eine "exaktere Wissenschaft" benötigt werden, schlage ich vor, dass Sie ein Framework wie das in dieser Beitragsreihe beschriebene implementieren.

Wir hoffen, dass diese Beitragsreihe für Sie hilfreich ist und freuen und besonders, wenn Sie beim Lesen Neues dazugelernt haben.

Viel Erfolg!

Eric Norberg

Service Engineer

Office 365

Dies ist ein übersetzter Blogbeitrag. Den Originalartikel finden Sie unter Establishing Exchange Content Index Rebuild Baselines – Part 3